サービス概要

FSx for NetApp ONTAPとは、NetAppのONTAPファイル システム技術に基づいて構築された信頼性の高い高性能のファイル ストレージを提供するAWSのフルマネージドファイル ストレージサービスです。

〔主な機能〕

- 使い慣れた ONTAP 機能: オンプレミスの ONTAP 導入でお客様が得られる、スナップショット、クローン作成、レプリケーション、柔軟なストレージ管理などの機能を提供します。

- ハイパフォーマンス: データベース、ホーム ディレクトリ、分析ワークロードなどの一般的なワークロードに、低遅延の SSD ベースのストレージを提供します。

- シンプルな管理: ONTAP インフラストラクチャのプロビジョニング、構成、メンテナンスを処理するため、お客様はハードウェアの管理について心配する必要がありません。

- セキュリティとアクセス制御: ID とアクセス管理のためのAD統合をサポートしています。また、保存中および転送中のデータの暗号化も提供します。

- バックアップと災害復旧: 災害復旧のための信頼性の高いバックアップ、復元、リージョン間のレプリケーション機能を提供します。

目的・やりたいこと

〔調査事項〕

- ADの設定でフォルダに対するアクセス権限が付与できるか?

- ADで定義したグループ単位でアクセス権限が付与できるか?

- フォルダに対するアクセス権限の設定方法

- GUIで設定可能か?

- 設定ファイルのインポートなどで、一括で設定することは可能か?

- シャドウコピーと同等の機能はONTAPにもあるか?

-

フォルダ単位のクォータに対して、下記のようなことは実現可能か?

・クォータの消費率に対して、閾値を設けてのアラート送信

・フォルダごとのクォータ消費率の出力

-

フォルダ毎のクォータの消費率を確認する方法

- 監査ログを閲覧する方法 S3やCloudWatchに転送する設定はなかったかと思うので、ONTAP管理画面かWindows Serverから確認する形になるかと思いますが、具体的な確認方法が分からず。

- 監査ログは「過去1年間保存、直近3ヶ月分は即調査可能な状態にする」と要件があります。1年後にログを削除するような設定はあるか?

対象となる技術

条件(導入にあたっての前提事項)

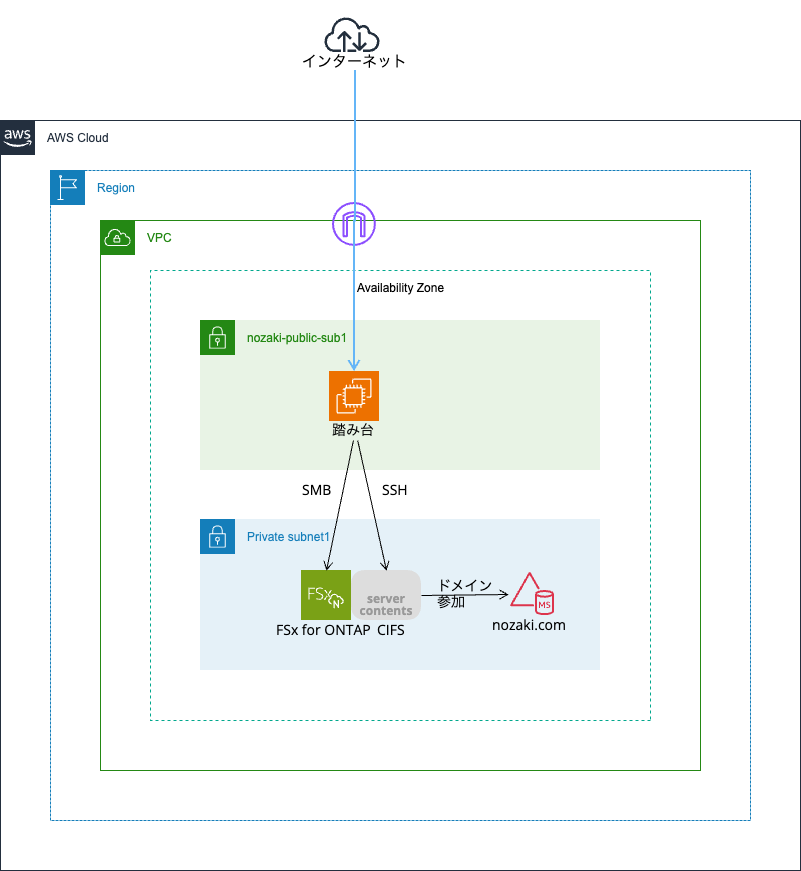

- パブリックサブネットに置いた踏み台用Windows、プライベートサブネットのManaged ADはあらかじめ作成済みとします。

参考URL

注意事項

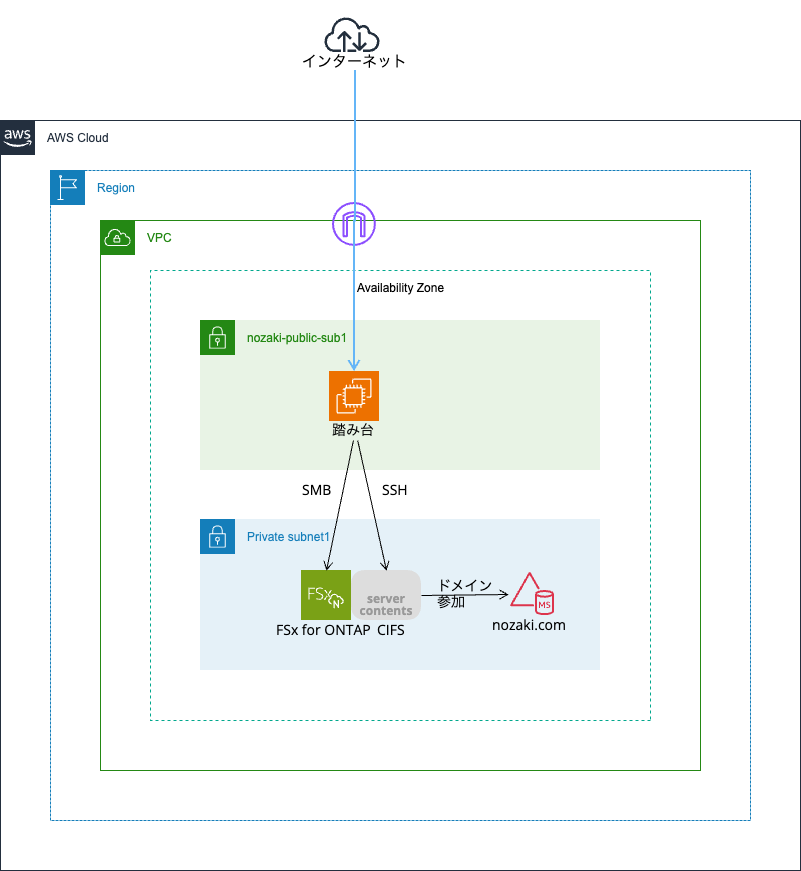

概要図

作業の流れ

事前作業

まずはFSx for ONTAPを構築します。

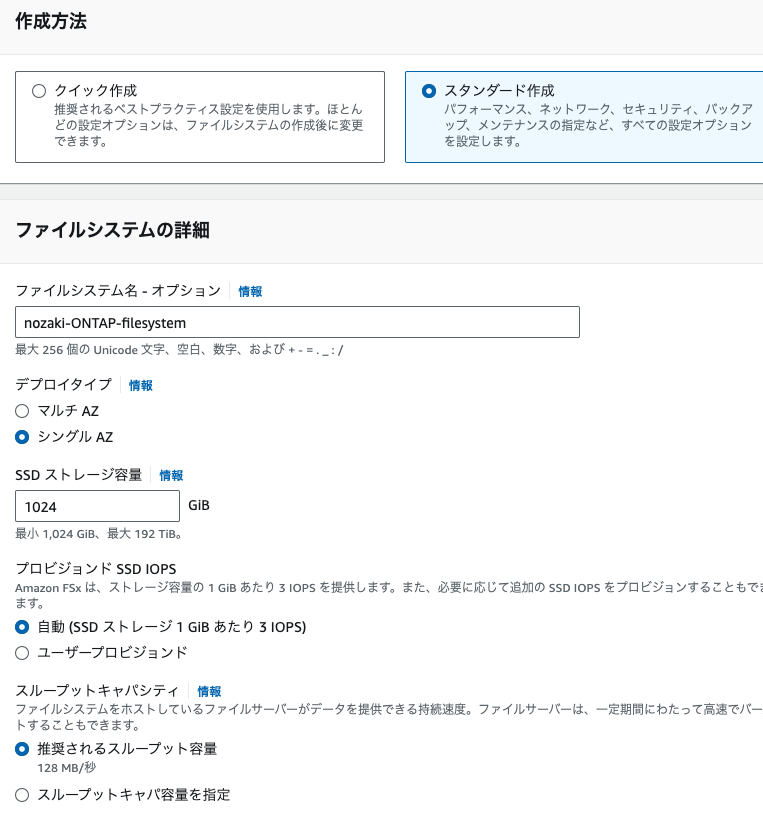

1.[ファイルシステムを作成]

2.[Amazon FSx for NetApp ONTAP]を選択

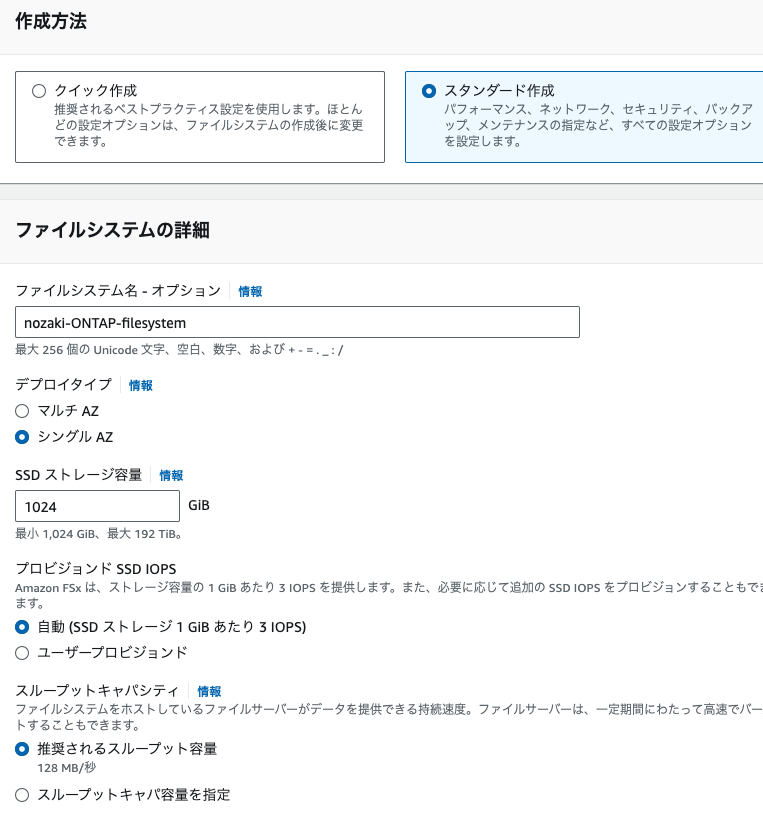

3.スタンダード作成で以下のように入力

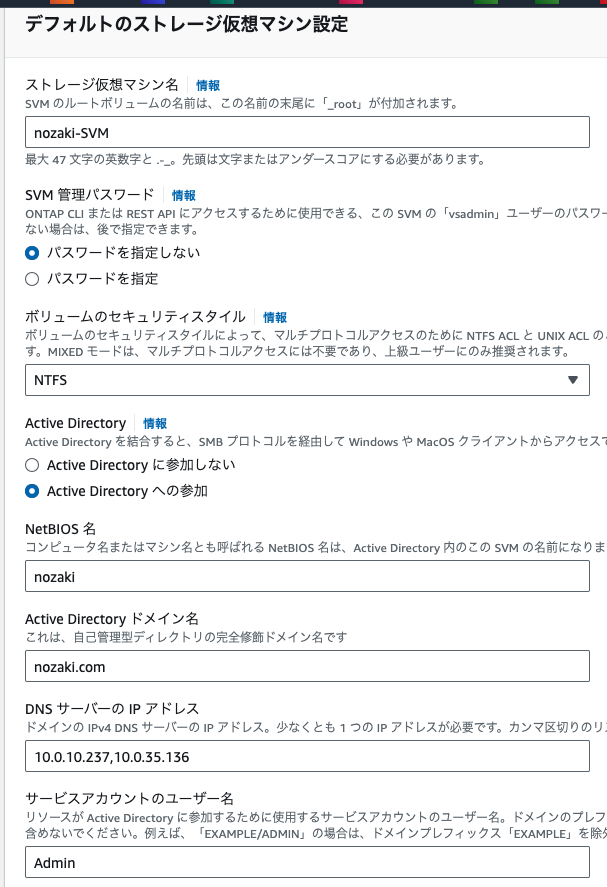

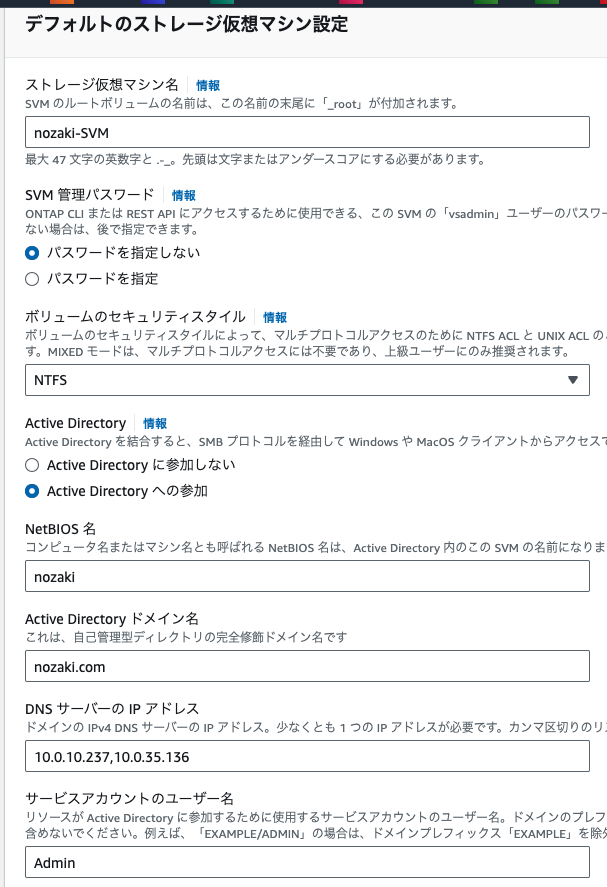

4.デフォルトのストレージ仮想マシン設定で以下のように入力

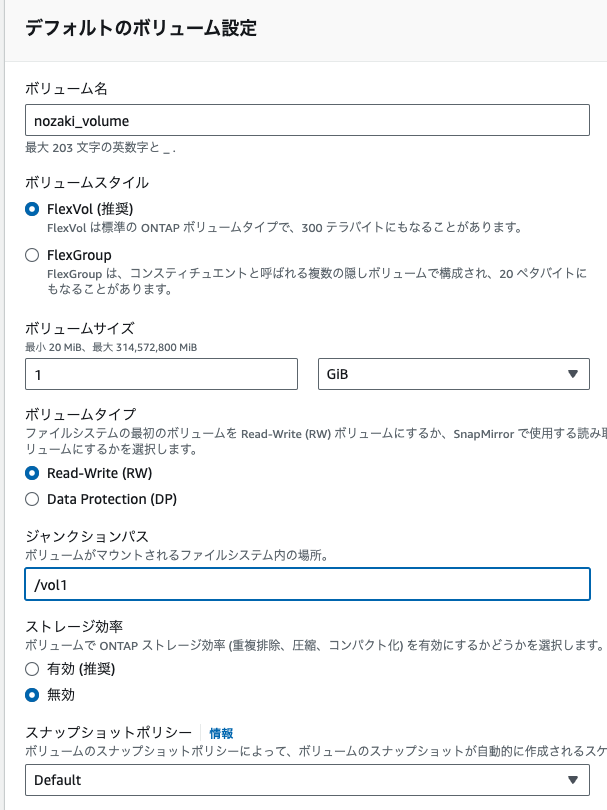

5.デフォルトのボリューム設定で以下のように入力

6.それ以外はデフォルトでOKで、確認および作成

「作成後に編集可能」が❌になっているものに注意して[ファイルシステムを作成]

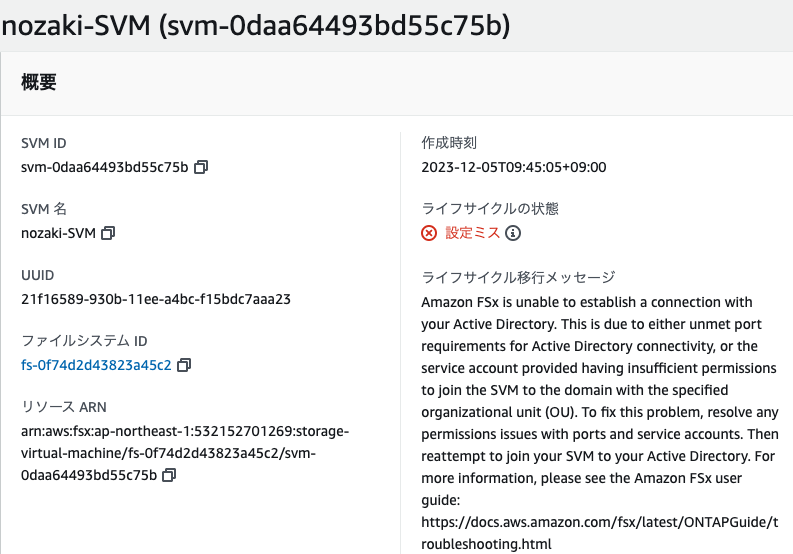

7.[ファイルシステム][ボリューム][ストレージ仮想マシン(SVM)]のステータスを確認

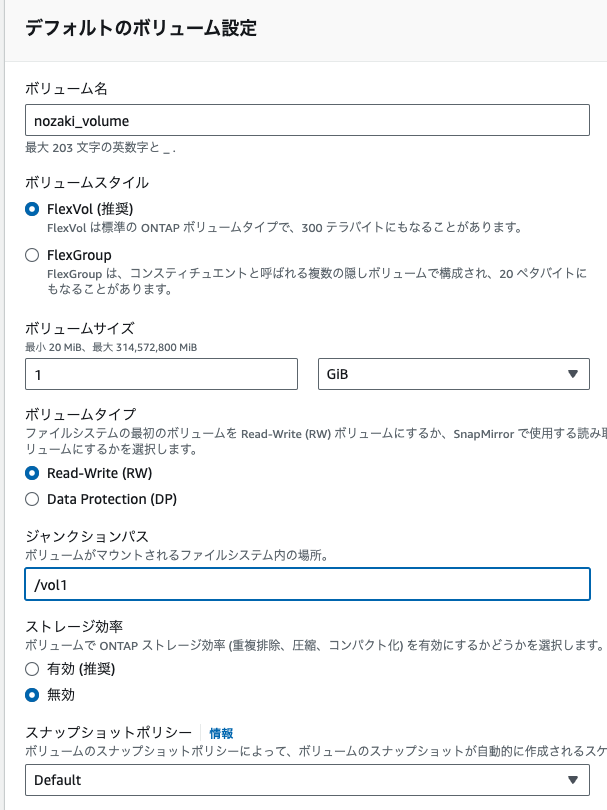

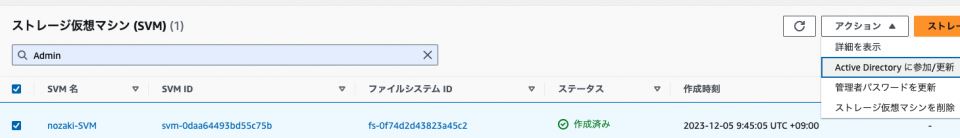

ところがSVMで設定ミス

エラーメッセージを翻訳すると以下ということらしい。

受け取ったエラーメッセージは、Amazon FSx が Active Directory との接続を確立できないことを示しています。これは、ポート要件が満たされていないこと、または提供されたサービス アカウントの権限が不十分であることが原因である可能性があります。

この問題を解決するには、まず、Amazon FSx ドキュメントに記載されているポート要件が満たされていることを確認します。ネットワークと FSx の間でポート 389、3268 ~ 3269、88、135、445、および 464 が開いていることを確認します。

次に、サービス アカウントに必要な権限があることを確認します。このアカウントには、指定された組織単位(OU)を持つドメインにストレージ仮想マシン(SVM)を参加させるための権限が必要です。

最後に、ポート要件とサービス アカウント権限をチェックアウトする場合は、SVM への参加時に指定した OU が存在し、アクセス可能であることを再確認します。

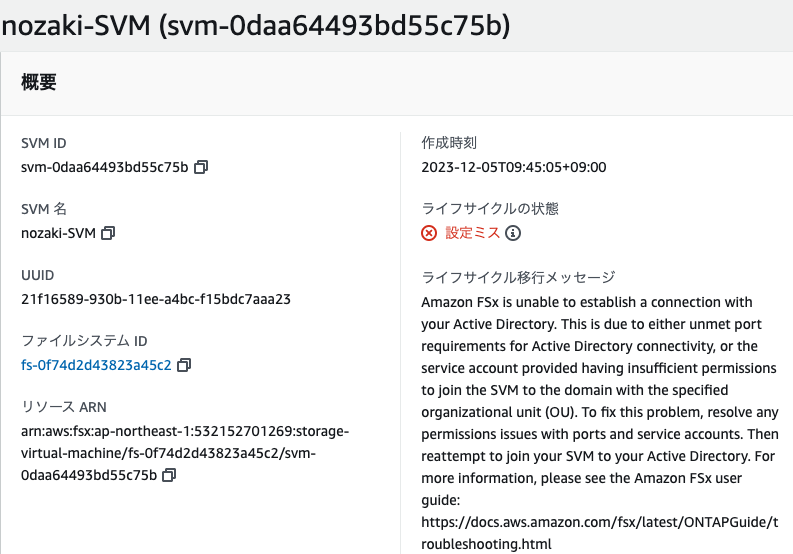

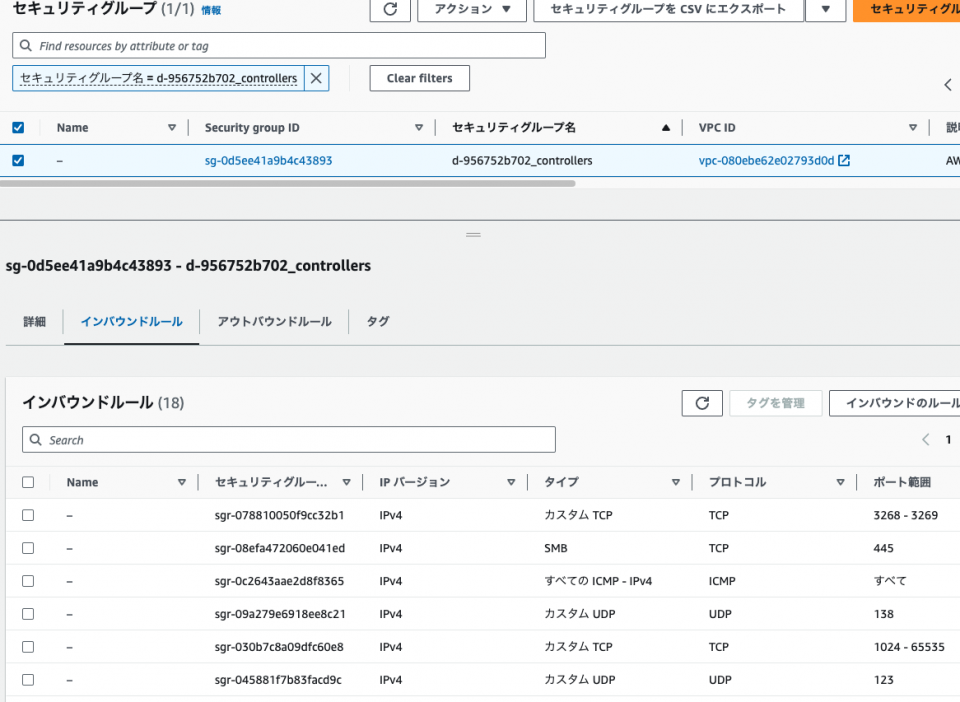

ところが、ADのSG「d-956752b702_controllers」では、このようにデフォルトで必要なポートがあらかじめ全部空いている。

一応FSxのSGもデフォルトのものに色々付け足しておいたが、それでも通らない。

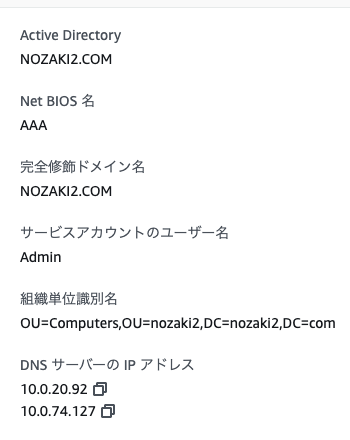

そこで、参考サイトを参考にこのように設定してみた。

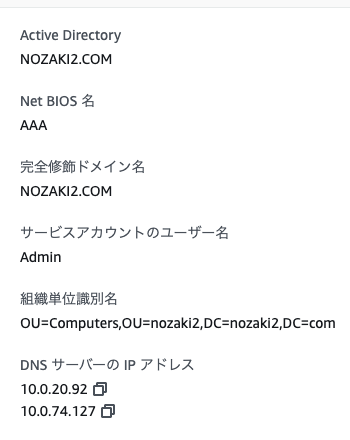

ポイントは、NetBIOS名が今まで「nozaki2」にしてたんだが、それだとドメインの一部だからダメということで怒られたので、適当な名前に

あとはOUを「OU=Computers, OU=nozaki2, DC=nozaki2, DC=com」のように指定してみたら通った!OUってオプション項目なのに実は必須だったという酷さ・・

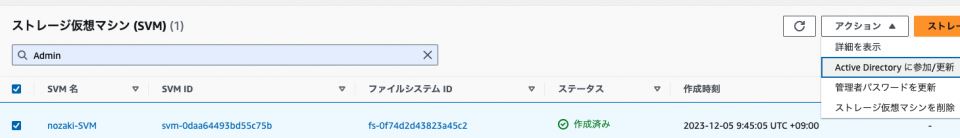

8.この状態で[ADに参加/更新]でnozaki2.comをリトライ。あっさり「作成済み」に

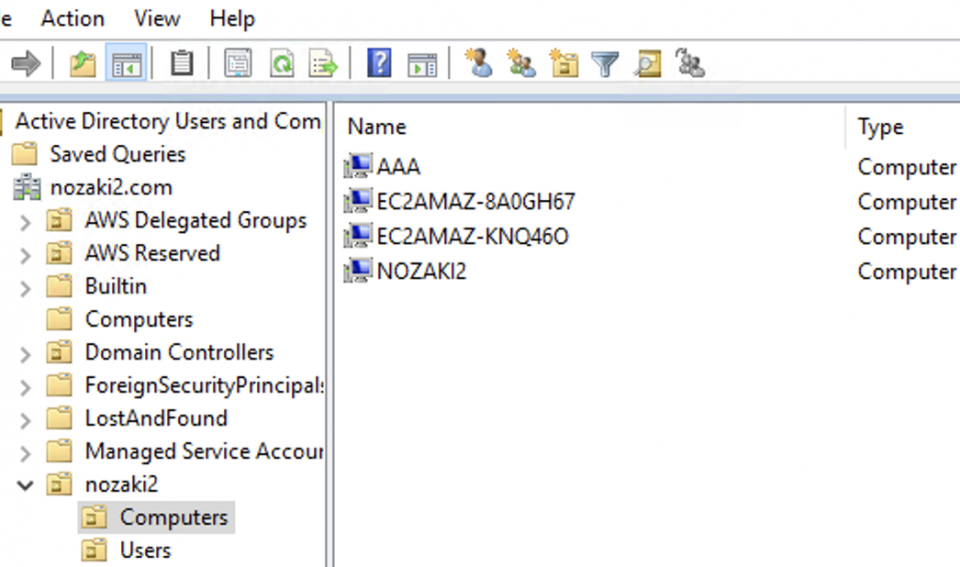

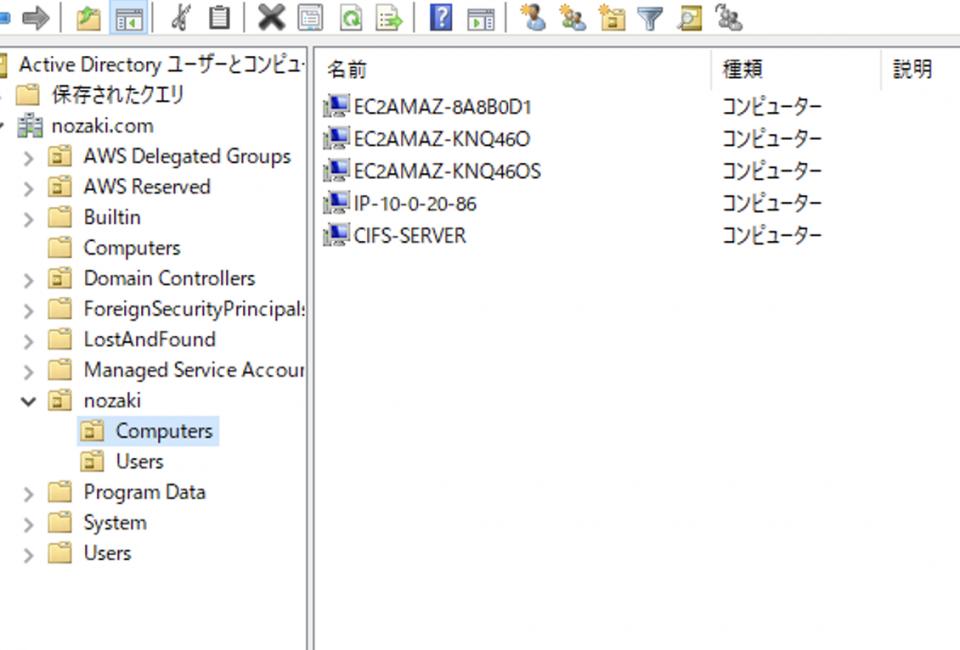

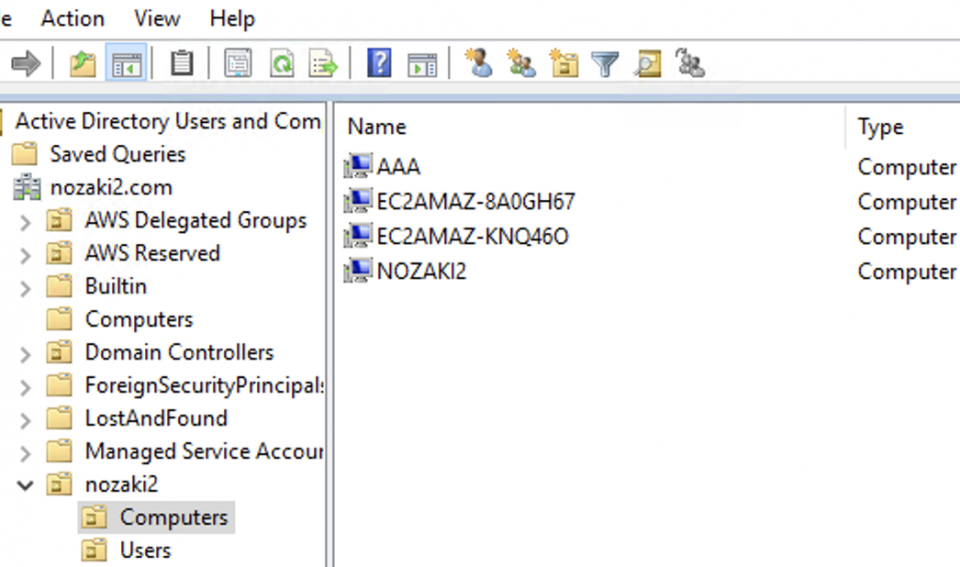

ADから見ても、ComputersにAAAとNOZAKI2がいるのを確認

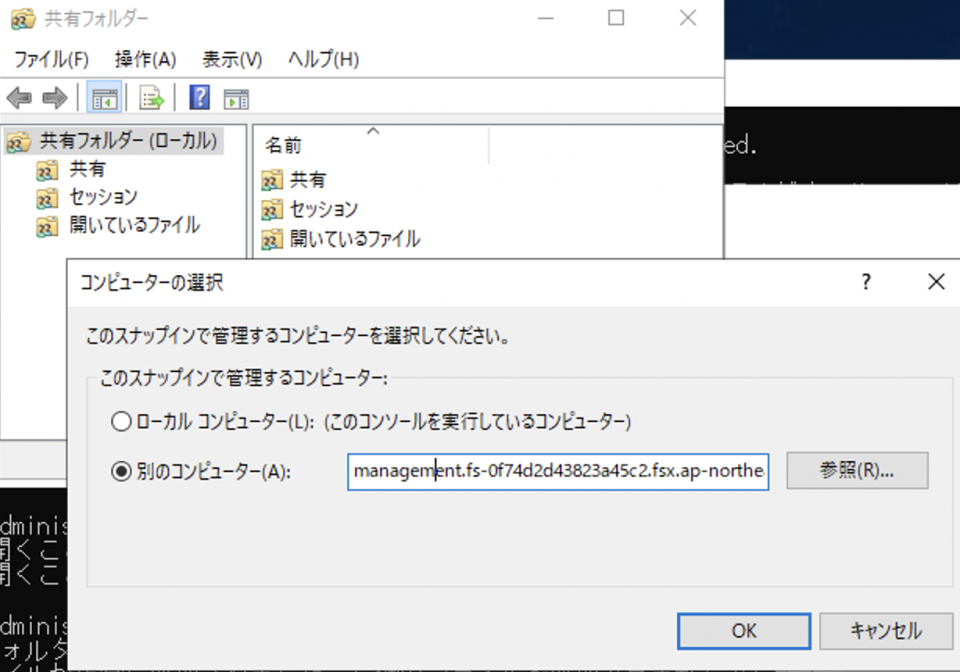

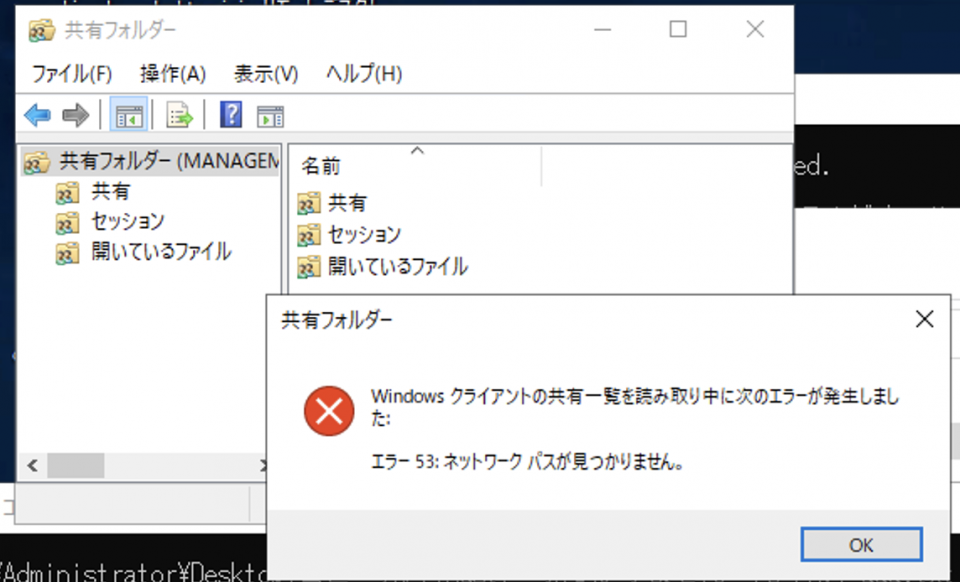

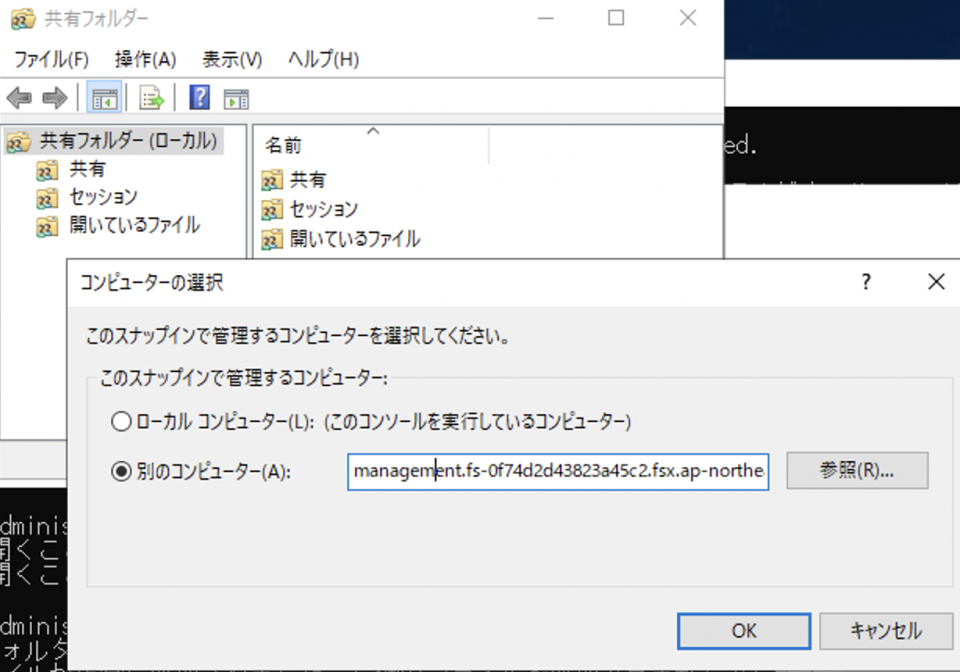

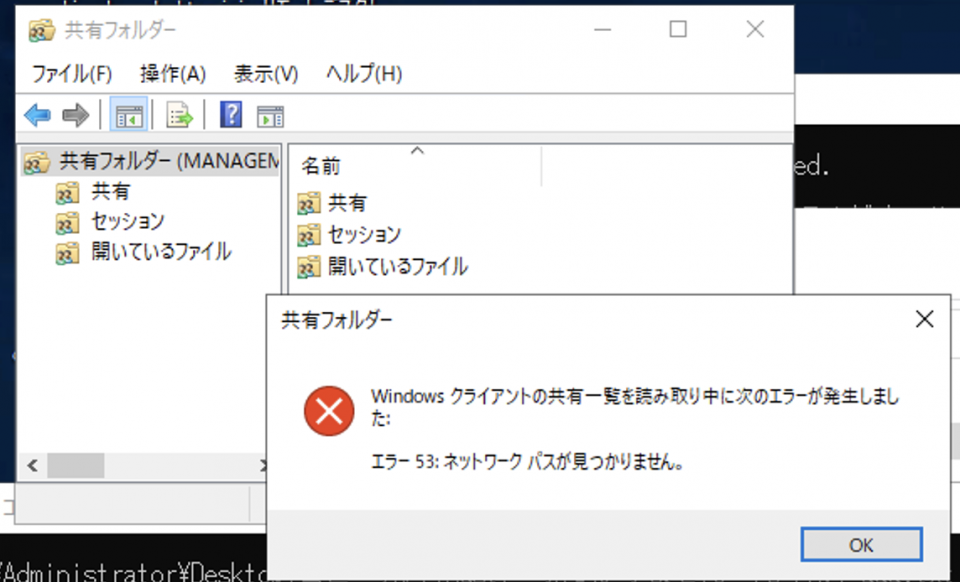

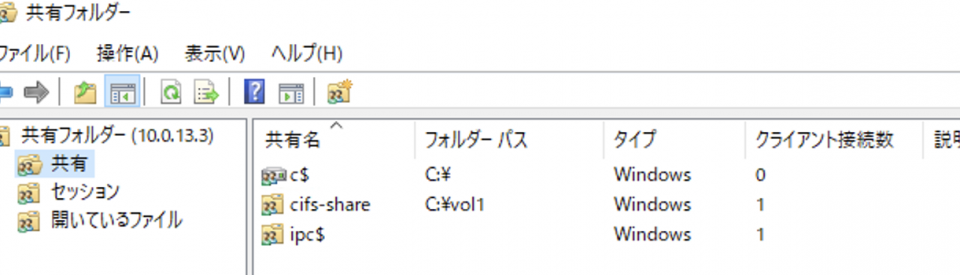

9.踏み台からfsmgmt.mscコマンドを使ってONTAPを共有してみる

ところがここでまたしてもエラー

そうこうして何度もONTAPを再作成しているうちに、またもやドメインに参加できない事態に・・なぜか奇跡的にドメインに参加できた上記↑が再現できない

なのでここで方針転換。WORKGROUPに所属するCIFSサーバーを立てて、マウントしてみることにする。

1.踏み台からFSx for ONTAPファイルシステムにSSHで接続

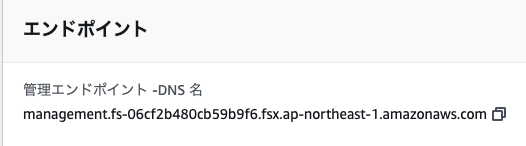

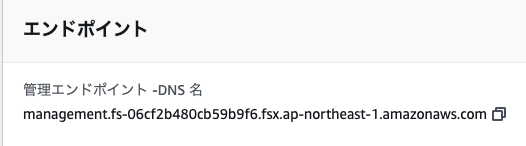

$ ssh fsxadmin@management.fs-06cf2b480cb59b9f6.fsx.ap-northeast-1.amazonaws.com

Password:

This is your first recorded login.

Unsuccessful login attempts since last login: 2

Your privilege has changed since last login.

ここでホスト名は、ファイルシステムの管理エンドポイントのDNS名参照

2.CIFSサーバーの作成

FsxId06cf2b480cb59b9f6::> vserver cifs create -vserver nozakiSVM -cifs-server cifs-server -workgroup fsxn-workgroup

Notice: SMB1 protocol version is obsolete and considered insecure. Therefore it is deprecated and disabled on this CIFS server. Support for SMB1 might be removed in a future

release. If required, use the (privilege: advanced) "vserver cifs options modify -vserver nozakiSVM -smb1-enabled true" to enable it.

FsxId06cf2b480cb59b9f6::> vserver cifs show

Server Status Domain/Workgroup Authentication

Vserver Name Admin Name Style

----------- --------------- --------- ---------------- --------------

nozakiSVM CIFS-SERVER up FSXN-WORKGROUP workgroup

「CIFS-SERVER」というCIFSサーバーを立てました。

3.CIFSユーザーの作成

FsxId06cf2b480cb59b9f6::> vserver cifs users-and-groups local-user create -vserver nozakiSVM -user-name nozaki -is-account-disabled false

Enter the password:

Confirm the password:

FsxId06cf2b480cb59b9f6::> vserver cifs users-and-groups local-user show -instance

Vserver: nozakiSVM

User Name: CIFS-SERVER\Administrator

Full Name:

Description: Built-in administrator account

Is Account Disabled: true

Vserver: nozakiSVM

User Name: CIFS-SERVER\nozaki

Full Name: -

Description: -

Is Account Disabled: false

2 entries were displayed.

「CIFS-SERVER\nozaki」というCIFSユーザーを作成しました。

4.CIFSファイル共有の作成

FsxId06cf2b480cb59b9f6::> volume show

Vserver Volume Aggregate State Type Size Available Used%

--------- ------------ ------------ ---------- ---- ---------- ---------- -----

nozakiSVM nozakiSVM_root

aggr1 online RW 1GB 972.0MB 0%

nozakiSVM vol1 aggr1 online RW 1TB 860.5GB 0%

2 entries were displayed.

FsxId06cf2b480cb59b9f6::> volume show -fields junction-path

vserver volume junction-path

--------- -------------- -------------

nozakiSVM nozakiSVM_root /

nozakiSVM vol1 /vol1

2 entries were displayed.

FsxId06cf2b480cb59b9f6::> vserver cifs share create -vserver nozakiSVM -share-name cifs-share -path /vol1

FsxId06cf2b480cb59b9f6::> vserver cifs share show -vserver nozakiSVM

Vserver Share Path Properties Comment ACL

-------------- ------------- ----------------- ---------- -------- -----------

nozakiSVM c$ / oplocks - BUILTIN\Administrators / Full Control

browsable

changenotify

show-previous-versions

nozakiSVM cifs-share /vol1 oplocks - Everyone / Full Control

browsable

changenotify

show-previous-versions

nozakiSVM ipc$ / browsable - -

3 entries were displayed.

vol1に「cifs-share」というファイル共有を作成しました。

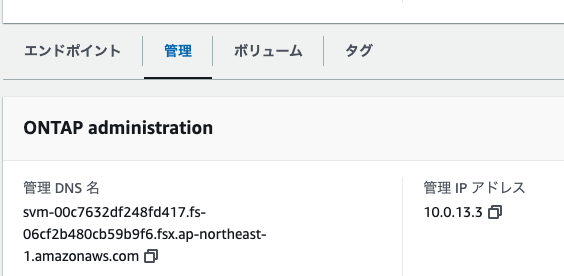

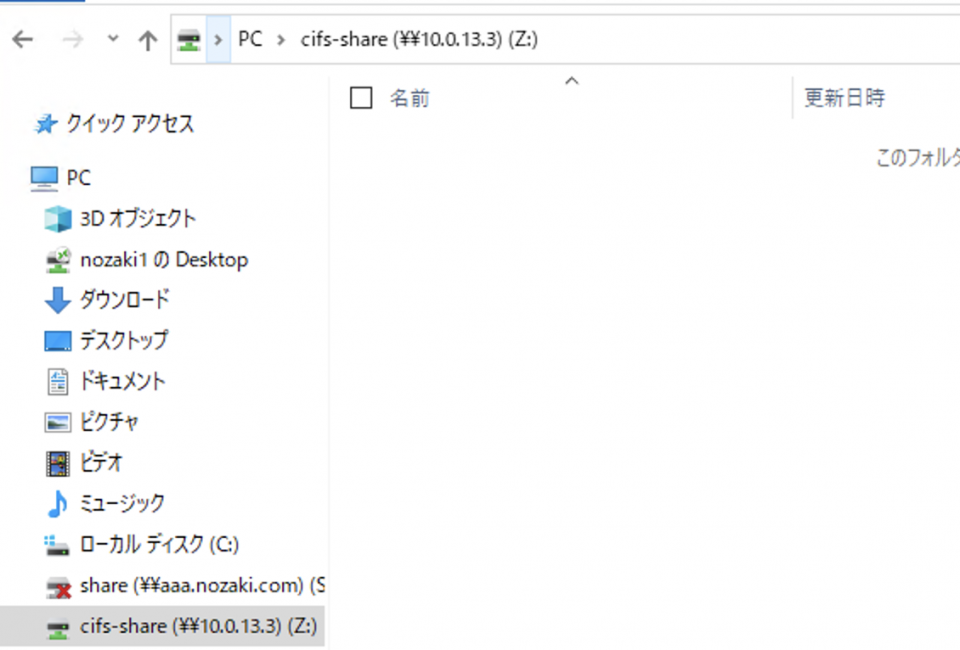

5.踏み台のPowershellを使って、CIFSユーザーの認証情報でSMBでZドライブにボリュームをマウント

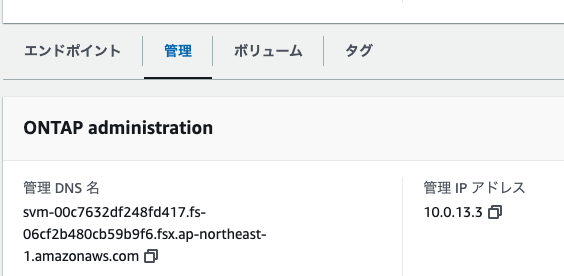

PS C:\Users\Administrator> net use Z: \\10.0.13.3\cifs-share

\\10.0.13.3\cifs-share のパスワードが無効です。

'10.0.13.3' のユーザー名を入力してください: CIFS-SERVER\nozaki

10.0.13.3 のパスワードを入力してください:

コマンドは正常に終了しました。

ここではSVMの以下のIPを使ってアクセスしました。

また、共有名は「cifs-share」、ユーザー名は「CIFS-SERVER\nozaki」になることに注意。

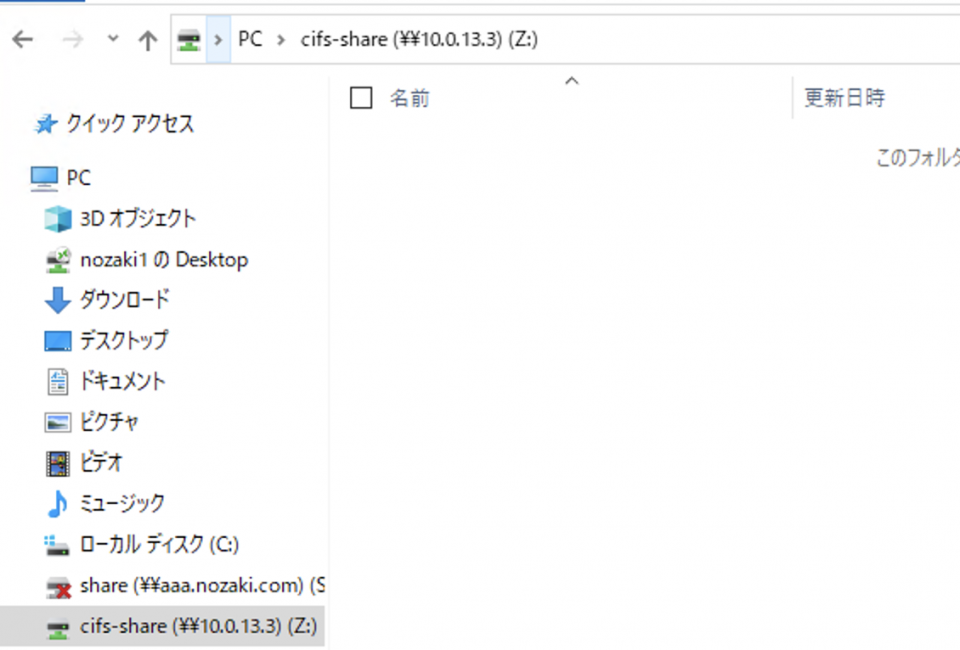

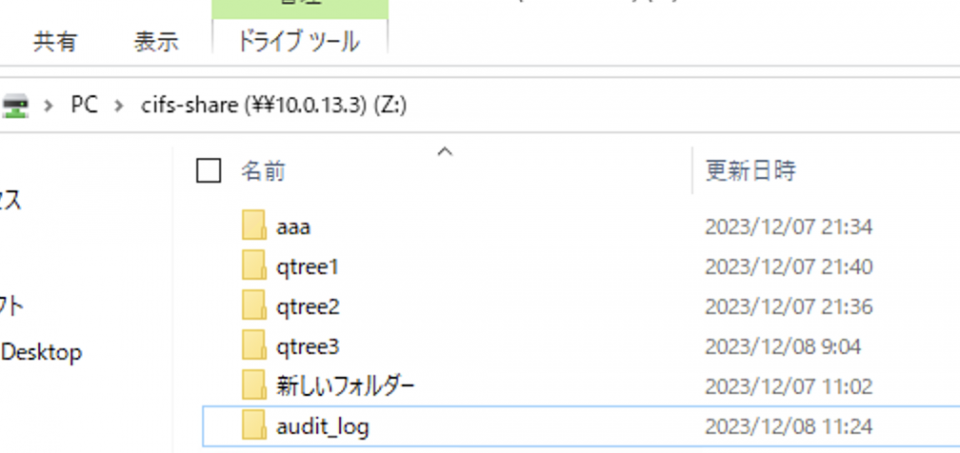

6.マウントできていることを確認

CIFSサーバーをドメインに参加させる手順

1.SVMが参照するDNSサーバーとして、ディレクトリサービス「nozaki.com」のDNSアドレスを指定

FsxId06cf2b480cb59b9f6::> dns create -vserver nozakiSVM -domains nozaki.com -name-servers 10.0.10.237

Warning: Only one DNS server is configured. Configure more than one DNS server to avoid a single-point-of-failure.

FsxId06cf2b480cb59b9f6::> dns show -instance

Vserver: nozakiSVM

Domains: nozaki.com

Name Servers: 10.0.10.237

Timeout (secs): 2

Maximum Attempts: 1

FsxId06cf2b480cb59b9f6::> dns check -vserver nozakiSVM -name-server 10.0.10.237

Vserver: nozakiSVM

Name Server: 10.0.10.237

Name Server Status: up

Status Details: Response time (msec): 0

2.ステータスをdownにしてCIFSサーバーをドメインに参加

と、ここでエラーが

FsxId06cf2b480cb59b9f6::> vserver cifs modify -vserver nozakiSVM -cifs-server CIFS-SERVER -domain nozaki.com -status-admin down

In order to create an Active Directory machine account for the CIFS server, you must supply the name and password of a Windows account with sufficient privileges to add

computers to the "CN=Computers" container within the "NOZAKI.COM" domain.

Enter the user name: Admin

Enter the password:

Error: Machine account creation procedure failed

[ 8140] Loaded the preliminary configuration.

[ 8154] Successfully connected to ip 10.0.10.237, port 88 using

TCP

[ 8196] Successfully connected to ip 10.0.10.237, port 389 using

TCP

**[ 8209] FAILURE: Could not create account

** 'cn=CIFS-SERVER,CN=Computers,dc=NOZAKI,dc=COM': an LDAP

** constraint violation occurred, which may indicate the

** supplied user has insufficient privilege to add an

** account in the specified organizational unit

Error: command failed: Failed to create the Active Directory machine account "CIFS-SERVER". Reason: LDAP Error: The user has insufficient access rights.

どうやらOUをちゃんと指定してなかったのが原因らしい。気を取り直して再チャレンジ

FsxId06cf2b480cb59b9f6::> vserver cifs modify -vserver nozakiSVM -cifs-server CIFS-SERVER -domain nozaki.com -status-admin down -ou ou=NOZAKI

In order to create an Active Directory machine account for the CIFS server, you must supply the name and password of a Windows account with sufficient privileges to add

computers to the "ou=NOZAKI" container within the "NOZAKI.COM" domain.

Enter the user name: Admin

Enter the password:

FsxId06cf2b480cb59b9f6::> vserver cifs show -instance

Vserver: nozakiSVM

CIFS Server NetBIOS Name: CIFS-SERVER

NetBIOS Domain/Workgroup Name: NOZAKI

Fully Qualified Domain Name: NOZAKI.COM

Organizational Unit: ou=NOZAKI

Default Site Used by LIFs Without Site Membership:

Workgroup Name: -

Authentication Style: domain

CIFS Server Administrative Status: up

CIFS Server Description:

List of NetBIOS Aliases: -

祝・念願のドメイン参加成功!

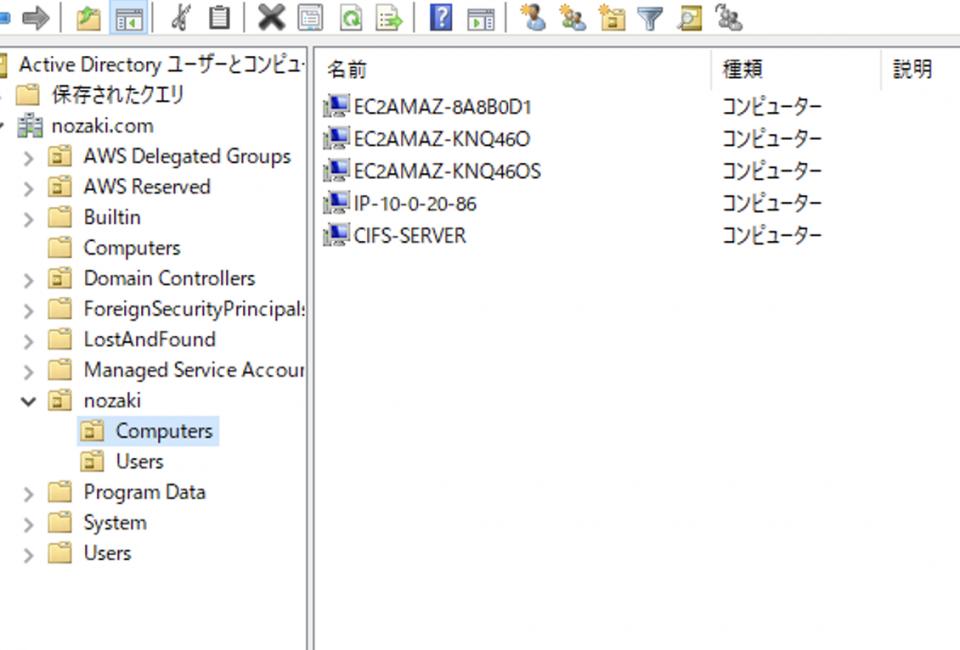

3.CIFSサーバーが指定したOU「nozaki」上に作成されたことを確認

Get-ADComputer -Filter "*" -SearchBase "DC=nozaki,DC=com"

〜略〜

DistinguishedName : CN=CIFS-SERVER,OU=nozaki,DC=nozaki,DC=com

DNSHostName : CIFS-SERVER.NOZAKI.COM

Enabled : True

Name : CIFS-SERVER

ObjectClass : computer

ObjectGUID : 0cc3c66c-4065-47aa-9e2c-ea2a01765950

SamAccountName : CIFS-SERVER$

SID : S-1-5-21-1702849902-3745289662-1852962917-1202

UserPrincipalName :

最後の方にちゃんといました!

ところがこれがADのGUI上だとコンピュータが見れないし、AWSマネジメントコンソールからだとドメイン参加が確認できない。どうやら表示にかなりタイムラグがあるらしい。

しかしこれも30分ほど経つとようやく表示された!

こうして見ると「ou=NOZAKI」になってるな。そもそもドメインになかなか参加できなかったのはOUの指定が間違ってたのかもしれない。。

と思ったら、ADで見たら変な場所にCIFSコンピュータが作られていたので移動した。「ou=NOZAKI, ou=Computers」が正解だったのかも

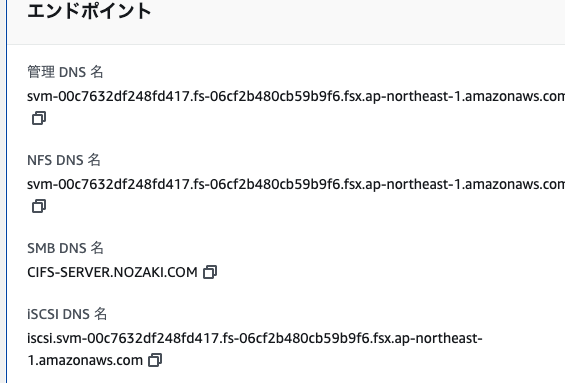

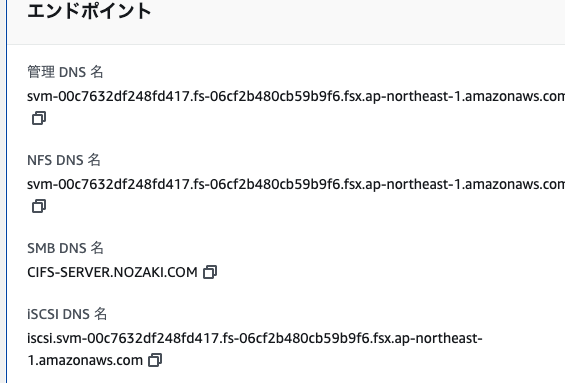

SMB DNS名も表示されていることを確認

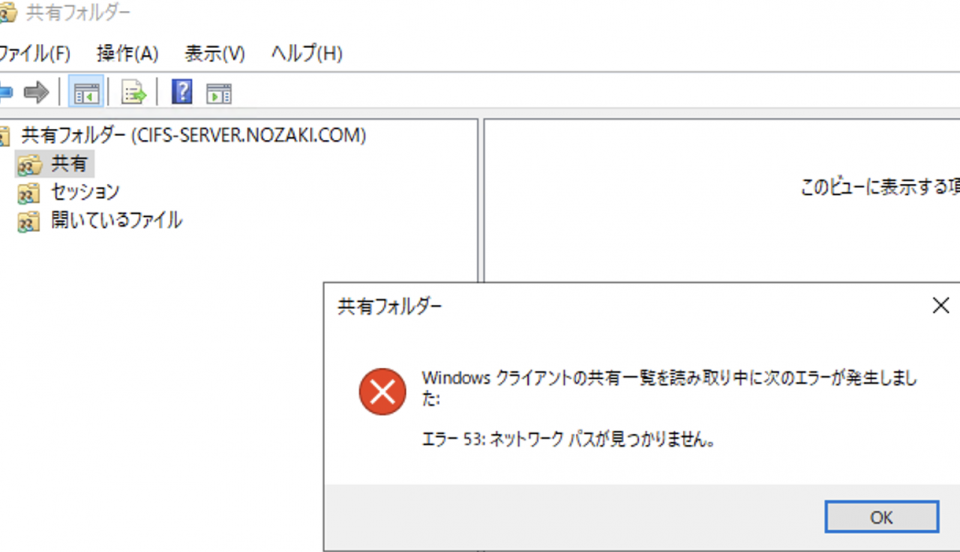

4.気を取り直してファイル共有にチャレンジ

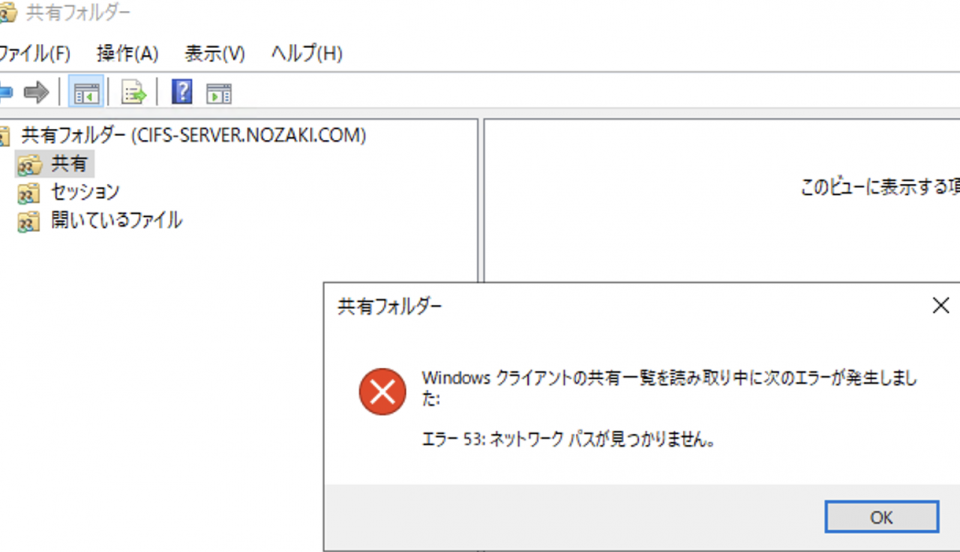

ところがまたしても上記と同じエラー

そこで権限が足りないのだと思い、

ONTAP CLI を使用して SVM をアクティブディレクトリに接続する

この参加後に共有にアクセスできない場合は、共有にアクセスするために使用しているアカウントにアクセス許可が付与されていることを確認してください。例えば、 AWS マネージド Active Directory でデフォルトAdminアカウント (委任管理者) を使用している場合は、ONTAP で次のコマンドを実行する必要があります。netbios_domain は Active Directory のドメイン名に対応します (corp.example.com の場合、ここで使用される netbios_domain は example です)。

vserver cifs users-and-groups local-group add-members -vserver svm_name -group-name BUILTIN\Administrators -member-names netbios_domain\admin

を参考に、NOZAKI\Domain UsersをBUILTIN\Administratorsに入れてみました。

FsxId06cf2b480cb59b9f6::> cifs users-and-groups local-group show-members

Vserver Group Name Members

-------------- ---------------------------- ------------------------

nozakiSVM BUILTIN\Administrators CIFS-SERVER\Administrator

NOZAKI\Domain Admins

BUILTIN\Guests NOZAKI\Domain Guests

BUILTIN\Users NOZAKI\Domain Users

3 entries were displayed.

FsxId06cf2b480cb59b9f6::> cifs users-and-groups local-group add-members -vserver nozakiSVM -group-name BUILTIN\Administrators -member-names "NOZAKI\Domain Users"

FsxId06cf2b480cb59b9f6::> cifs users-and-groups local-group show-members

Vserver Group Name Members

-------------- ---------------------------- ------------------------

nozakiSVM BUILTIN\Administrators CIFS-SERVER\Administrator

NOZAKI\Domain Admins

NOZAKI\Domain Users

BUILTIN\Guests NOZAKI\Domain Guests

BUILTIN\Users NOZAKI\Domain Users

3 entries were displayed.

5.ファイル共有再チャレンジ

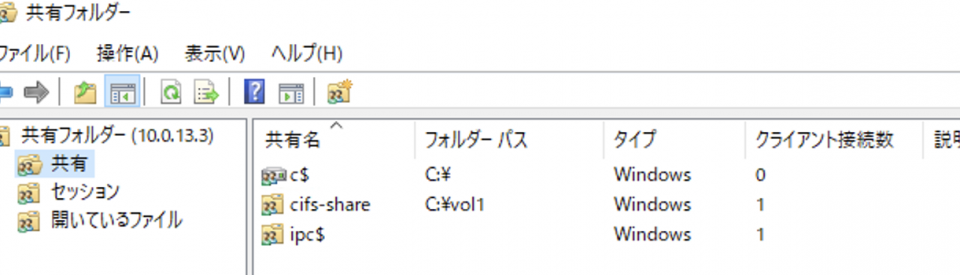

さらに今度はSMB DNS名「CIFS-SERVER.NOZAKI.COM」ではなく、IP「10.0.13.3」直打ちでアクセスにし行く。

すると今度は共有一覧が普通に表示された!

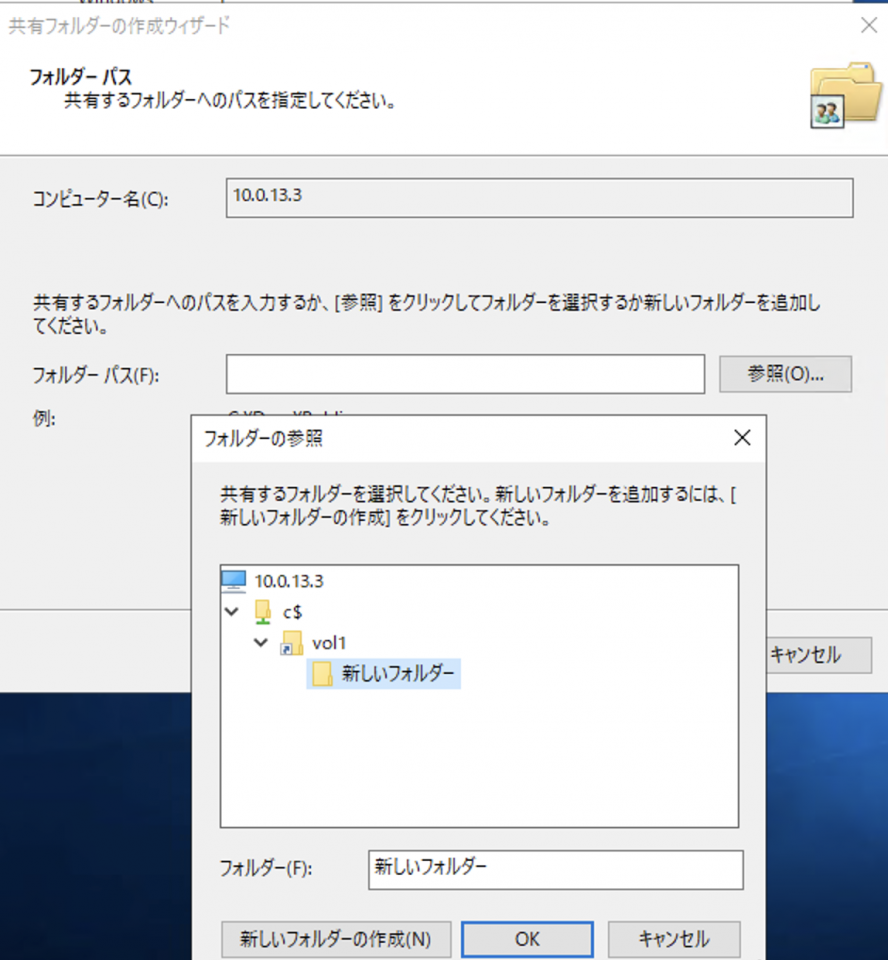

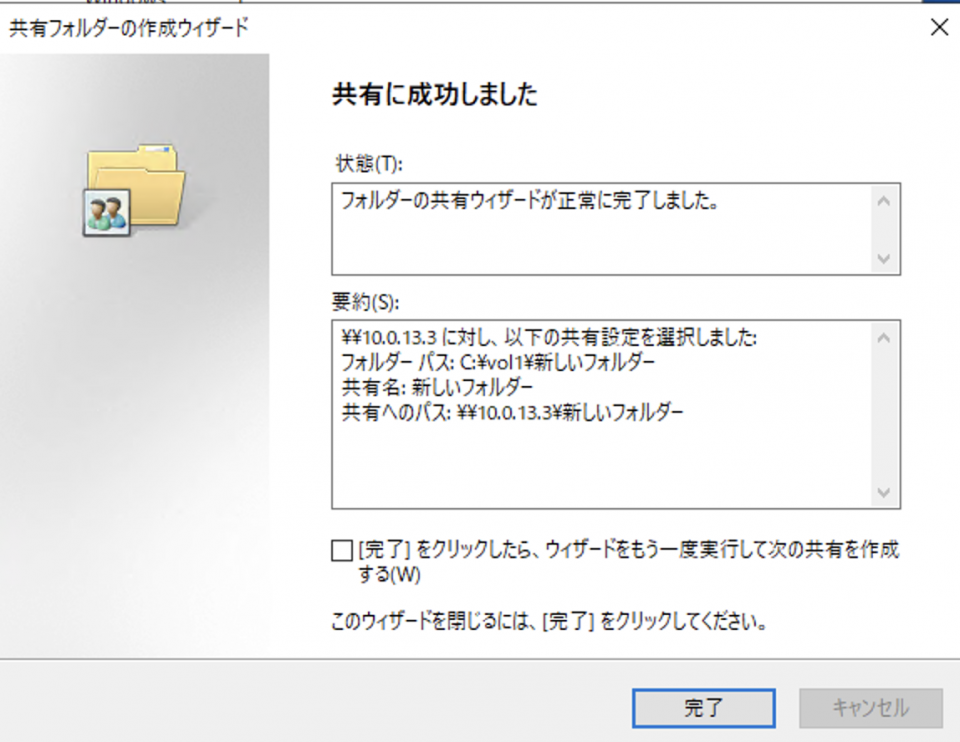

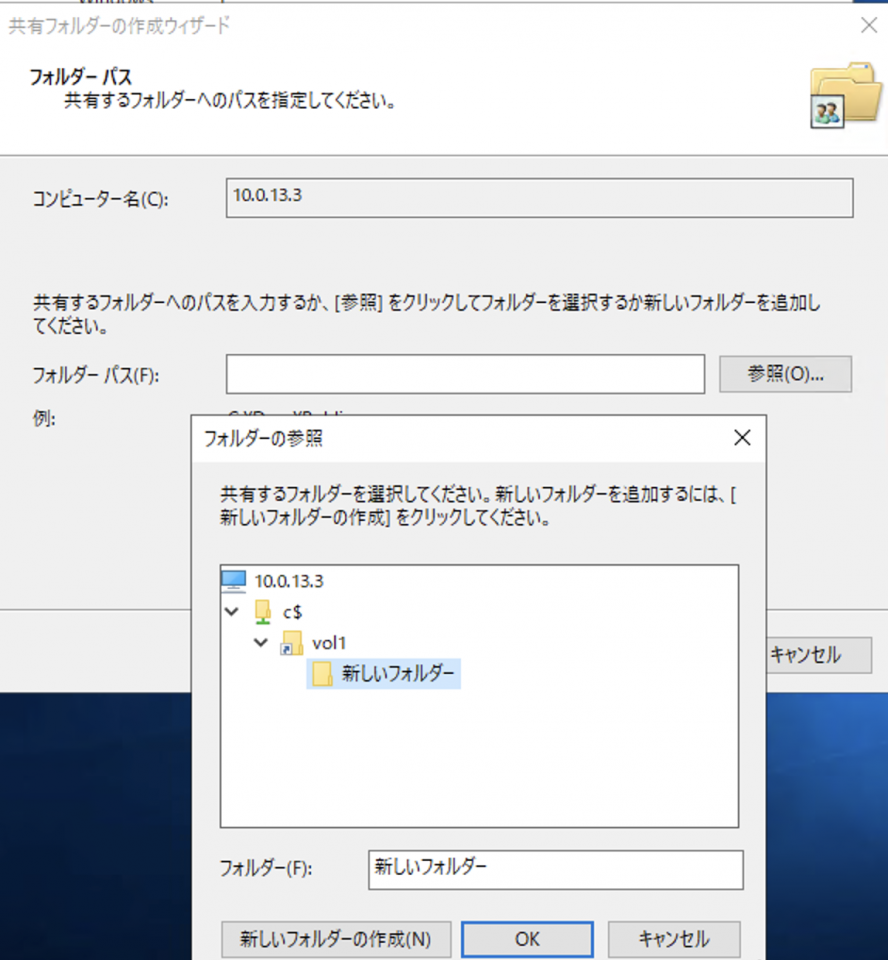

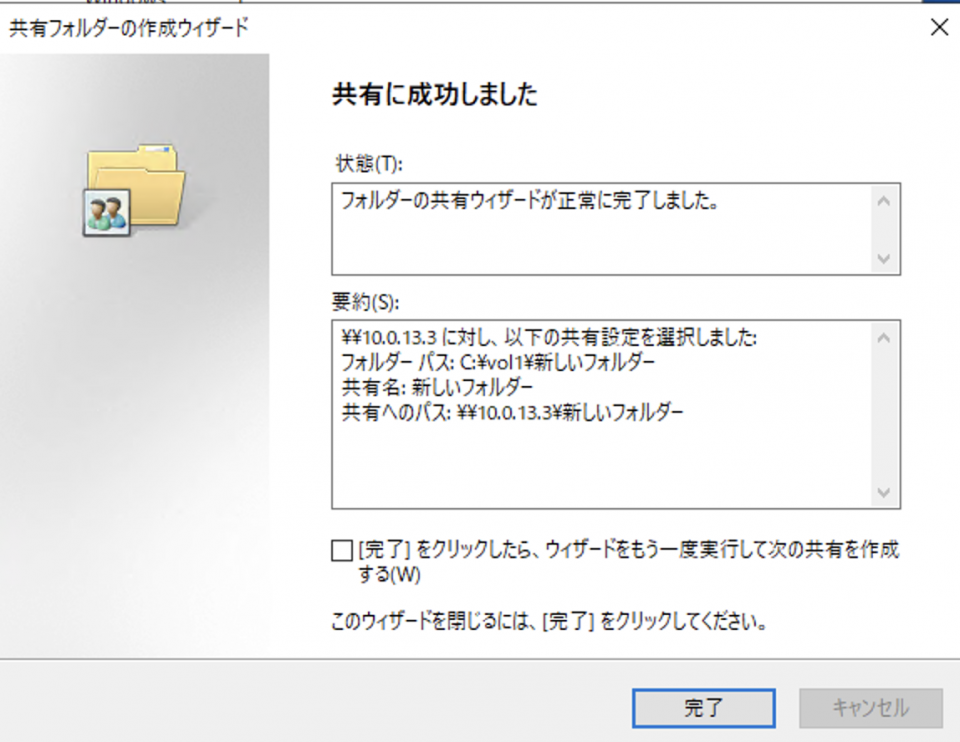

新しい共有で「新しいフォルダー」を共有にしてみる

無事共有成功

手順

以降では課題を確認していく

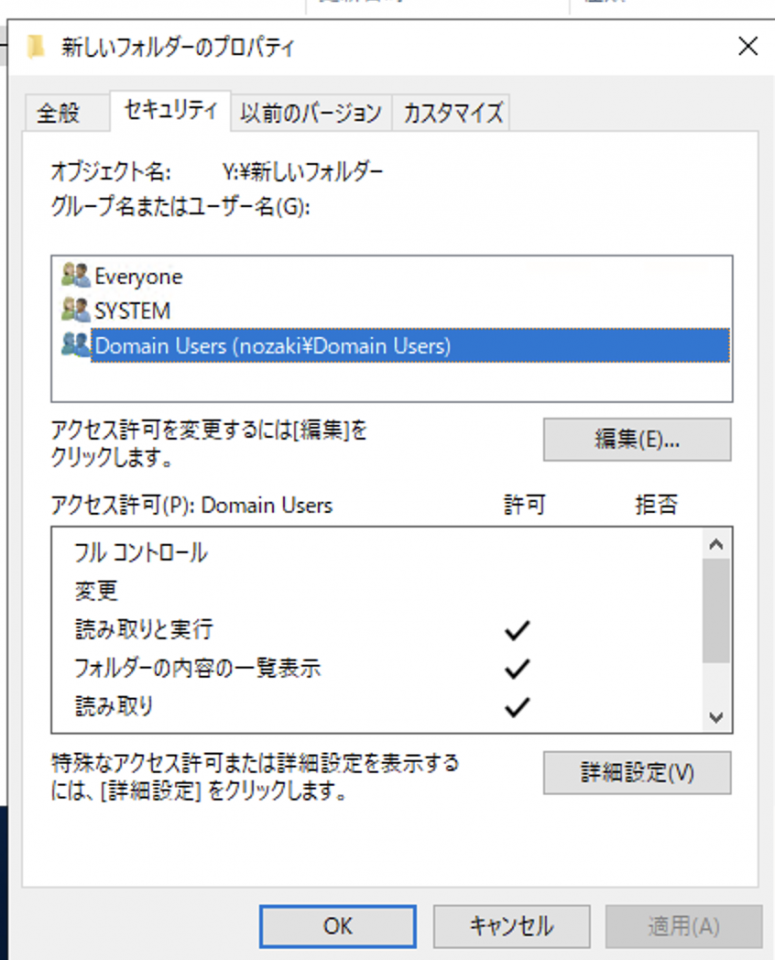

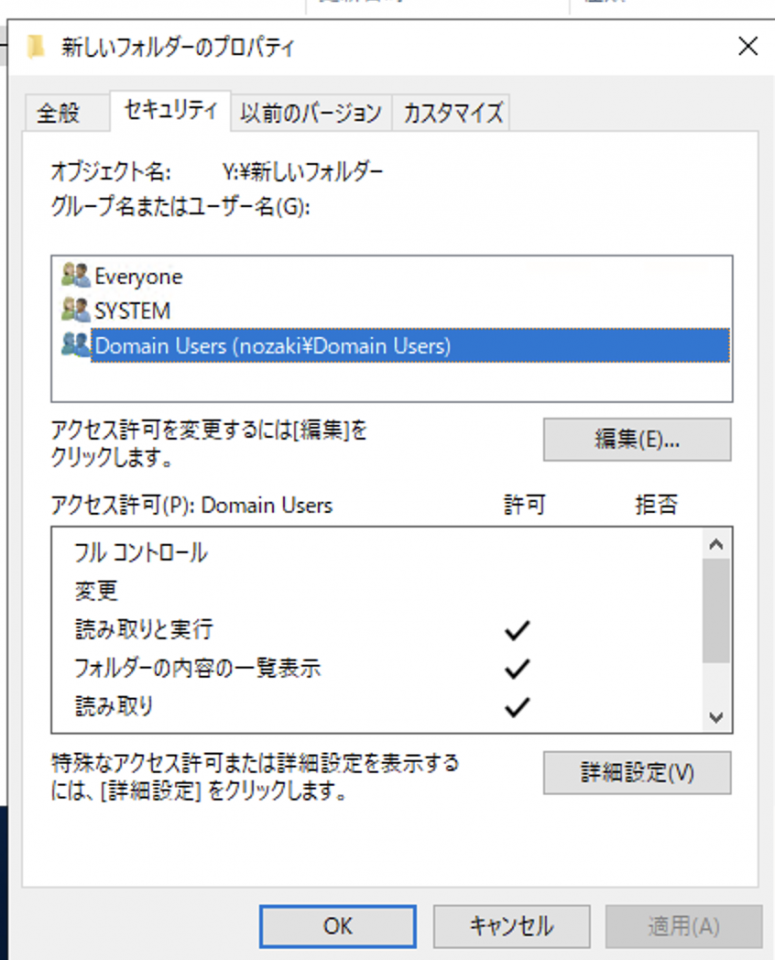

1. ADの設定でフォルダに対するアクセス権限が付与できるか?

2. ADで定義したグループ単位でアクセス権限が付与できるか?

3. フォルダに対するアクセス権限の設定方法

4. GUIで設定可能か?

例えばこのようにDomain UsersというグループをGUIでフォルダに対してアクセス権をつけることができた。

5.設定ファイルのインポートなどで、一括で設定することは可能か?

この方法はなさそう。

6.シャドウコピーと同等の機能はONTAPにもあるか?

はい、スナップショット機能があります。

Working with snapshots

Snapshot ジョブスケジュールを作成

7.フォルダ単位のクォータに対して、下記のようなことは可能か?

・クォータの消費率に対して、閾値を設けてのアラート送信

・フォルダごとのクォータ消費率の出力

標準では、そのような細かいカスタマイズや設定は不可能です。

NetApp側の方でLambda関数を使用したFSx for ONTAPの監視方法のドキュメントが用意されていますので、ご活用ください。

・FSx for ONTAP の全体的なストレージ容量の使用状況

各ボリュームの使用量(シンプロビジョニング/シックプロビジョニング)

・使用状況の警告やサイズ変更の通知をEメールで受信するアラートメカニズム

8.フォルダ毎のクォータの消費率を確認する方法

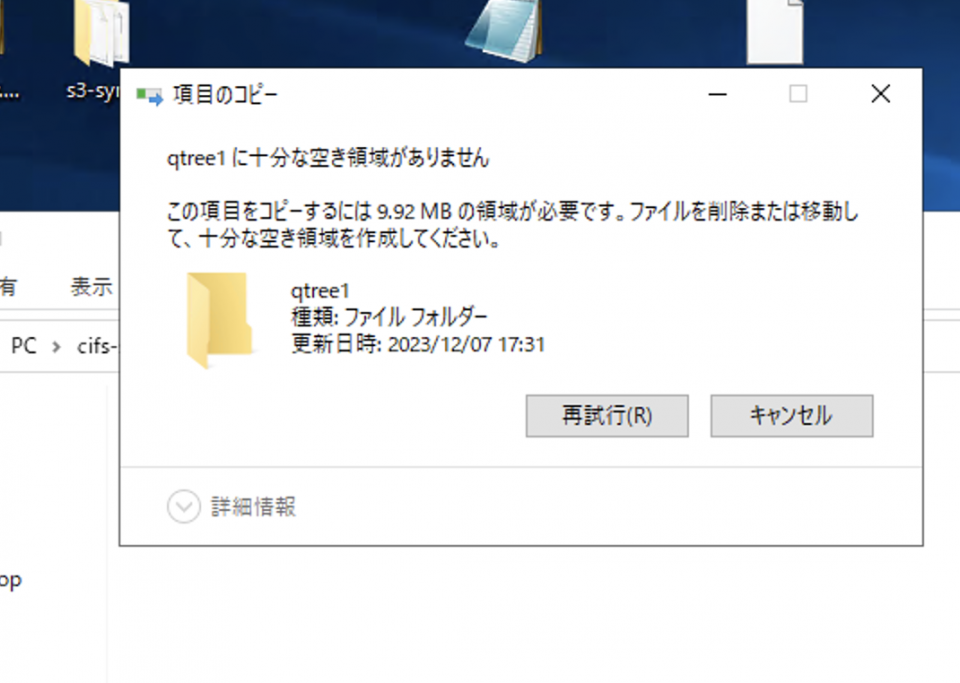

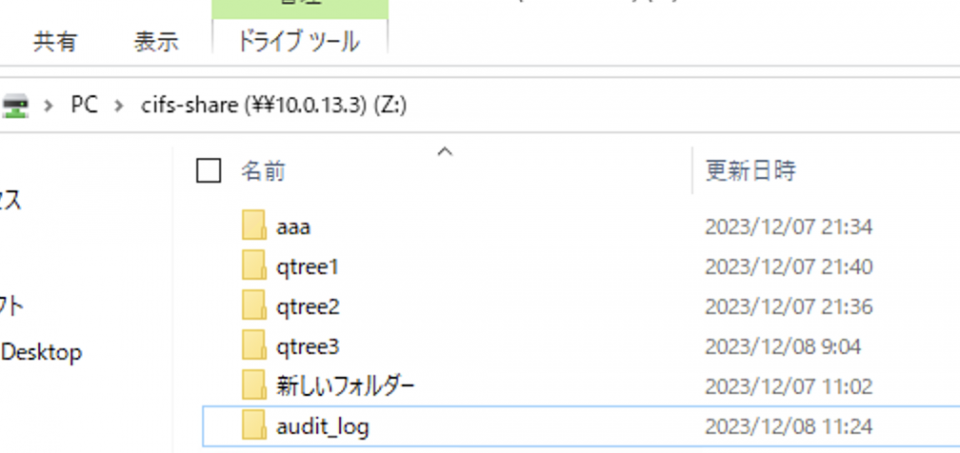

- qtree(vol1の下にqtree1)を作成する

FsxId06cf2b480cb59b9f6::> volume qtree create -vserver nozakiSVM -qtree-path /vol/vol1/qtree1 -security-style ntfs

- 「default」 policyに 1MB上限のクォータルールを作成する

FsxId06cf2b480cb59b9f6::> volume quota policy rule create -vserver nozakiSVM -policy-name default -volume vol1 -type user -target "" -disk-limit 1MB -qtree qtree1

FsxId06cf2b480cb59b9f6::> volume quota on -vserver nozakiSVM -volume vol1 -foreground true

[Job 57] Job is queued: "quota on" performed for quota policy "default" on volum

[Job 57] Running: sending quota rules. 1 quota rules sent.

[Job 57] Job succeeded: Successful

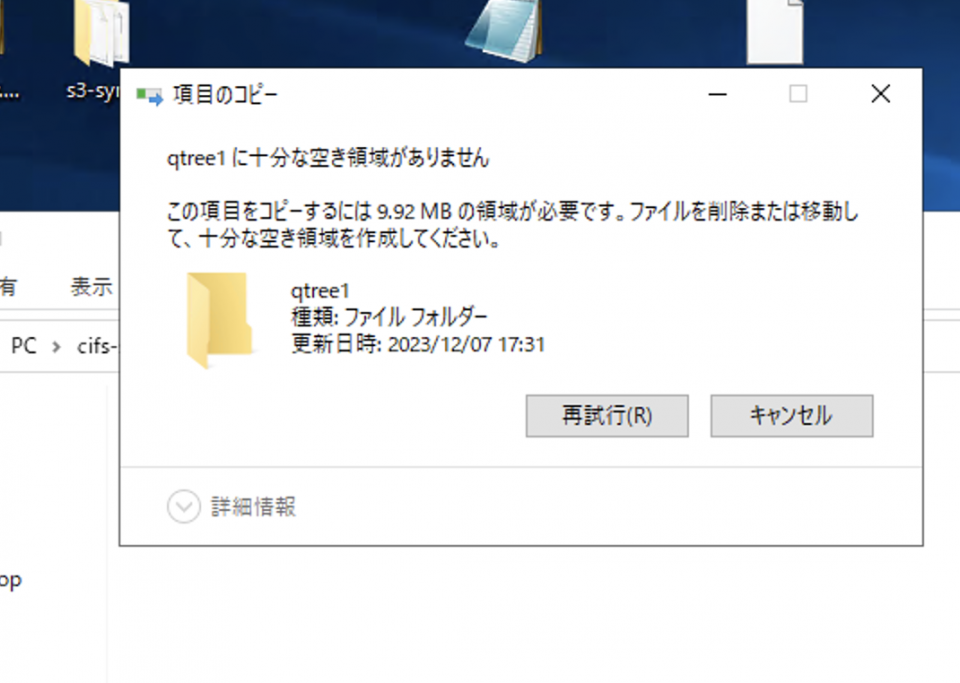

この状態で、例えば9.92MBあるファイルをqtree1下に移動しようとすると、1MB上限のクォータルールに抵触してエラーに

ここで課題、default以外のポリシーを作成するには?

あとはdefaultポリシーにどんどんルールを追加していけばいいだけなのですが、中には「default」という名前が嫌、複数のポリシーを作成できないの?という疑問を持つ方もいるかもしれません。

その辺りの仕様はこちら

クォータルール、クォータポリシー、およびクォータとは

1つのSVMに最大5つのクォータポリシーを保持できるため、クォータポリシーのバックアップコピーを保持できます。1つのSVMに割り当てられるクォータポリシーは常に1つです。

つまり、クォータポリシー自体は5つまで作成できるけど、実際にSVMに割り当てられるのは1つだけだよと。

実際にdefaultを削除して別のポリシー名を割り当てる方法はこちら

ONTAP FlexGroup ボリュームベストプラクティス/インプリメンテーションガイドのP124.「第9章 qtree 9.2 FlexGroupによるクォータの管理」

必要なポリシーを使用するには、SVMを変更し、クォータをオフにしてからオンに戻す必要があります。

cluster::*> vserver modify -vserver DEMO -quota-policy tree

cluster::*> quota off -vserver DEMO *

cluster::*> quota policy rule delete -vserver DEMO -policy-name default *

1 entry was deleted.

cluster::*> quota on -vserver DEMO -volume flexgroup_local -foreground true

[Job 8084] Job succeeded: Successful

FsxId06cf2b480cb59b9f6::> volume quota report

Vserver: nozakiSVM

----Disk---- ----Files----- Quota

Volume Tree Type ID Used Limit Used Limit Specifier

------- -------- ------ ------- ----- ----- ------ ------ ---------

vol1 qtree1 user BUILTIN\Administrators

0B - 1 -

vol1 qtree1 user CIFS-SERVER\nozaki

32KB 1MB 4 - *

vol1 qtree1 user * 0B 1MB 0 - *

ご覧のようになぜか1個しか表示されない。使用量はわかるが使用率の表示はなし

でもルールを見ると、他のQtreeに対してもちゃんとLimitは設定されている。

FsxId06cf2b480cb59b9f6::> volume quota policy rule show -policy-name default -volume vol1

Vserver: nozakiSVM Policy: default Volume: vol1

Soft Soft

User Disk Disk Files Files

Type Target Qtree Mapping Limit Limit Limit Limit Threshold

----- -------- ------- ------- -------- ------- ------ ------- ---------

user "" aaa off 2MB - - - -

user "" qtree1 off 1MB - - - -

user "" qtree2 off 2MB - - - -

user "" qtree3 off 1KB - - - -

user "" test off 1MB - - - -

5 entries were displayed.

大幅な変更後のクォータの再初期化によると、クォータをレポートに反映させるには、クォータを設定する都度再初期化(volume quota設定のOFF⇨ON)が必要なようです。

FsxId06cf2b480cb59b9f6::> volume quota off -vserver nozakiSVM -volume vol1 -foreground true

[Job 80] Job succeeded: Successful

FsxId06cf2b480cb59b9f6::> volume quota on -vserver nozakiSVM -volume vol1 -foreground true

[Job 81] Job succeeded: Successful

FsxId06cf2b480cb59b9f6::> volume quota report

Vserver: nozakiSVM

----Disk---- ----Files----- Quota

Volume Tree Type ID Used Limit Used Limit Specifier

------- -------- ------ ------- ----- ----- ------ ------ ---------

nozakiSVM_root

qtree3 user BUILTIN\Administrators

0B - 1 -

nozakiSVM_root

qtree4 user BUILTIN\Administrators

0B - 1 -

nozakiSVM_root

qtree3 user * 0B 1GB 0 - *

nozakiSVM_root

qtree4 user * 0B 1MB 0 - *

vol1 qtree1 tree 1

9.97MB 1GB 2 - qtree1

vol1 aaa tree 2

19.96MB 1GB 5 - aaa

vol1 qtree2 tree 3

19.95MB 1GB 3 - qtree2

vol1 qtree3 tree 4 8KB 1GB 2 - qtree3

vol1 tree * 0B 1GB 0 - *

9 entries were displayed.

これで課題は使用率の表示だけに。ONTAP上でファイルやスクリプトを作成したりすることはできないのでどうするか。。

使えるコマンドはこれだけ。

FsxId06cf2b480cb59b9f6::>

cluster event exit history job

lun man metrocluster network qos

redo rows san security set

snaplock snapmirror statistics statistics-v1 storage

system top up volume vserver

ちなみに、qtreeコマンドを実行することで、クォータ制限が可能なフォルダが作成されるというような動きっぽい。

既存のフォルダに対してqtreeを実行してクォータ制限をかけるみたいなことは出来なさそう。

例えば、aaaというフォルダを手動で作成した後、それに後からクォータを掛けてみる。

FsxId06cf2b480cb59b9f6::> volume qtree create -vserver nozakiSVM -qtree-path /vol/vol1/aaa -security-style ntfs

Error: command failed: Failed to create qtree "aaa" in volume "vol1" Vserver

"nozakiSVM". Reason: Qtree (or directory) "aaa" already exists.

このように既に存在すると怒られてしまってクォータを設定できない。

9.監査ログを閲覧する方法

ファイルアクセスの監査や、監査設定の作成参照

9.1. SVM での監査設定の作成

あらかじめ例えば「audit_log」というフォルダを作っておいてから、以下コマンドを実行。

FsxId06cf2b480cb59b9f6::> vserver audit create -destination /vol1/audit_log -events file-ops,cifs-logon-logoff -format evtx

9.2. SVM での監査の有効化

監査設定の設定が完了したら、SVM で監査を有効にする。

FsxId06cf2b480cb59b9f6::> vserver audit enable -vserver nozakiSVM

9.3. ファイルおよびフォルダの監査ポリシーを設定する

ユーザーアクセスの試みを監査するファイルおよびフォルダーに監査ポリシーを設定する。NTFS 監査ポリシーは、Windows のセキュリティタブまたは ONTAP CLI を使用して設定できるが、前者は死ぬほどめんどくさそうだったので、2行で済む後者をここでは選択

FsxId06cf2b480cb59b9f6::> vserver security file-directory policy create -vserver nozakiSVM -policy-name p1

FsxId06cf2b480cb59b9f6::> vserver security file-directory apply -vserver nozakiSVM -policy-name p1

[Job 89] Job is queued: Fsecurity Apply. Use the "job show -id 89" command to view the status of this operation.

AWSのドキュメントには、適用だけで作成のコマンドがなかったので注意

10.監査ログは「過去1年間保存、直近3ヶ月分は即調査可能な状態にする」という要件があり、1年後にログを削除するような設定は?

監査ログにはログローテート機能があります。これを月で例えば3月を指定すれば、毎年年度末にローテートされるようになるのではと

FsxId06cf2b480cb59b9f6::> vserver audit create -destination /vol1/audit_log -events file-ops,cifs-logon-logoff -format evtx -rotate-schedule-month

January February March April May June July

August September October November December

さらに-rotate-limitで世代数も設定できるので、これを1にすれば1世代バックアップで過去1年分だけ保存されるようになるのでは

[-rotate-limit ]- ログ ファイルのローテーション制限

このパラメータは、監査ログ ファイルのローテーション制限を指定します。値 0 は、すべてのログ ファイルが保持されることを示します。デフォルト値は 0 です。たとえば、値 5 を入力すると、最後の 5 つの監査ログが保持されます。

さらに、-retention-durationで保存期間を制限できる。

[-retention-duration <[d][h][m][s]>]- ログの保存期間 }

このパラメータは、監査ログ ファイルの保存期間を指定します。値 0 は、すべてのログ ファイルが保持されることを示します。デフォルト値は 0 です。たとえば、値 5d0h0m を入力すると、5 日以上経過したログが削除されます。

なので1年だったら「-retention-duration 365d」を指定すればよい。

以上をまとめると、

FsxId06cf2b480cb59b9f6::> vserver audit create -destination /vol1/audit_log -events file-ops,cifs-logon-logoff -format evtx -rotate-schedule-month March -rotate-limit 1 -retention-duration 365d

まとめ

- 動作が不安定(バグが多そう)

- フォルダごとのクォータを設定しても可視化できない

- qtreeやONTAPの情報がNetappのわかりにくい資料くらいしかない

- クォータ設定をレポートに反映させるには、その都度ディスクへのクォータの有効化をオンオフする必要がある

所要時間

3時間

フォルダ単位でクォータを設定したい場合